Prompt-Tipp: KI für Nachrichtenartikel - praktisch oder gefährlich?

___STEADY_PAYWALL___

Die Idee, journalistische Artikel durch KI erstellen zu lassen, ist bislang noch kaum verbreitet – und das aus gutem Grund. Die letzte Entscheidung und die kreative Gestaltung sollten weiterhin in den Händen menschlicher Journalist:innen bleiben.

Eine große Gefahr beim Einsatz von KI in der Nachrichtenproduktion ist die Möglichkeit, dass falsche Informationen generiert werden, was zu einem erheblichen Vertrauensverlust im Journalismus führen könnte. Trotzdem ist es spannend zu sehen, wie weit die Technologie bereits gekommen ist.

In diesem Kontext habe ich eine eigene kleine wissenschaftliche Untersuchung durchgeführt, um herauszufinden: „Kann KI den Prozess der Nachrichtenproduktion übernehmen?“

Dazu habe ich ein Experiment durchgeführt, das die Nachrichtenproduktion mit Agenturmaterial simuliert. Das Ziel des Experiments war es herauszufinden, ob Nachrichtenartikel, die von KI erstellt wurden, die wichtigsten journalistischen Qualitätskriterien erfüllen. Dabei wurde untersucht:

- Genauigkeit der Informationen: Können KI-erstellte Artikel korrekte und verlässliche Informationen liefern?

- Sprachliche Qualität: Entsprechen die generierten Texte den sprachlichen Standards des Journalismus?

- Objektivität und Ausgewogenheit: Sind die Berichte objektiv und ausgewogen oder zeigen sie Verzerrungen?

- Einfluss verschiedener Strategien des Prompting: Welche Auswirkungen haben unterschiedliche Prompting-Methoden auf die Qualität der generierten Inhalte?

Diese Ziele sind entscheidend, um zu verstehen, wie und unter welchen Bedingungen KI-Modelle wie ChatGPT in der Lage sind, qualitativ hochwertige journalistische Inhalte zu erstellen und die menschliche Arbeit in Redaktionen sinnvoll zu unterstützen.

Durchführung des Experiments

In meinem Experiment wurden Nachrichtenartikel zu drei verschiedenen Themen des Jahres 2023 erstellt:

- Parlamentswahl in Polen am 15.10.2023

- Urteil des deutschen Bundesverfassungsgerichts zum Nachtragshaushalt 2021 am 15.11.2023

- Versuchter Putsch der Wagner-Söldner gegen den russischen Staat am 23.06.2023

Als Quellen dienten Meldungen großer Nachrichtenagenturen auf Deutsch: Deutsche Presse-Agentur (DPA), Reuters (RTR) und Agence France-Presse (AFP). Insgesamt wurden 24 Nachrichtenartikel generiert, wobei jede mögliche Kombination von Agenturmeldungen verwendet wurde.

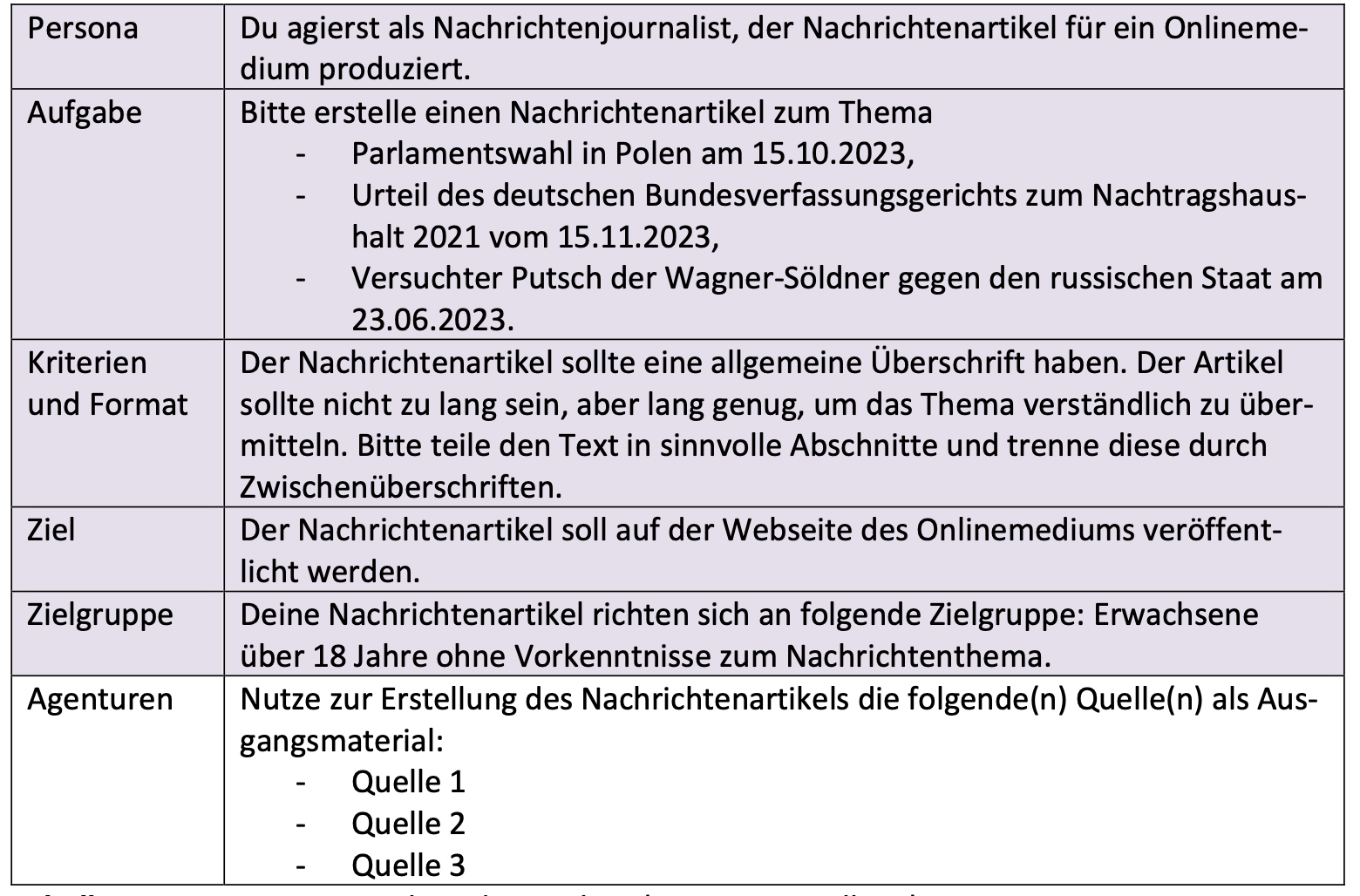

Genutzte Prompts

Jeder Prompt, den ich an ChatGPT gegeben habe, folgte einer festen Struktur. Diese Struktur beinhaltete stets folgende Elemente:

Forschungsmethode

Das Experiment folgte einer selbstgewählten Forschungsmethode zur Erstellung von Nachrichtenartikeln mit anschließender Inhaltsanalyse. Diese Inhaltsanalyse wurde anhand eines Codebuchs durchgeführt, das spezifische journalistische Qualitätskriterien festlegte und die Bewertung der Artikel standardisierte.

Ergebnisse der Analyse

Die generierten Artikel wurden anhand journalistischer Qualitätskriterien analysiert, darunter Richtigkeit, Vollständigkeit, Objektivität und sprachliche Qualität. Die Analyse ergab, dass die Qualität der Artikel stark von der Anzahl und Kombination der genutzten Agenturmeöldungen abhing.

- Zwei Agenturmeldungen: Die besten Ergebnisse wurden erzielt, wenn zwei verschiedene Agenturmeldungen verwendet wurden. Diese Artikel waren meist vollständig, korrekt und ausgewogen. Dies bestätigt das journalistische Zwei-Quellen-Prinzip.

- Eine oder drei Agenturmeldungen: Artikel, die auf nur einer Agenturmeldung basierten, wiesen häufig inhaltliche Lücken auf, während Artikel mit drei Meldungen oft überladen und weniger fokussiert waren.

Einige detaillierte Ergebnisse

- Richtigkeit und Vollständigkeit: Artikel, die aus zwei Quellen erstellt wurden, erfüllten am besten die Kriterien der Richtigkeit und Vollständigkeit. Diese Artikel konnten die wichtigsten Fakten klar und präzise darstellen, was ihre journalistische Qualität erheblich steigerte. Dennoch kam es vor allem bei einer oder drei Quellen, aber auch bei zwei Quellen, immer wieder zu Fehlern. Wichtige Protagonist:innen wurden ausgelassen oder falsch zugeordnet. Zusammenhänge wurden falsch erklärt.

- Sprachliche Qualität: Die sprachliche Qualität der Artikel war durchgehend hoch, unabhängig von der Anzahl der verwendeten Quellen. Die Texte waren klar strukturiert, gut lesbar und enthielten nur selten grammatikalische oder stilistische Fehler.

- Objektivität: Auch hier zeigten Artikel mit zwei Quellen die besten Ergebnisse, da sie eine ausgewogene Darstellung der Ereignisse ermöglichten. Sie waren weniger anfällig für Verzerrungen und boten eine umfassende Perspektive auf das jeweilige Thema. Bei einer oder drei Quellen kam es oft zu objektiv falschen Gewichtungen in der Beschreibung und Einführung von Fakten und Protagonist:innen.

Das Experiment zeigte, dass generative KI wie ChatGPT in der Lage ist, qualitativ hochwertige Nachrichtenartikel zu erstellen, insbesondere wenn präzises Prompting und eine sorgfältige Auswahl der Quellen erfolgt. Allerdings bleibt die menschliche Kontrolle unerlässlich, um die Richtigkeit und Relevanz der Informationen sicherzustellen.

Trotz der hohen sprachlichen Qualität, die von der KI erreicht wird, produziert sie immer noch inhaltliche Fehler, die das Ansehen des Journalismus schädigen können. Daher sollte die Nachrichtenproduktion nicht vollständig von KI übernommen werden. Das größte Problem der KI: Sie kann nicht verstehen und abwägen, welche Fakten und Personen im Artikel mit welcher Gewichtung und in welchem Zusammenhang genannt werden sollen.

KI kann jedoch weiterhin als wertvoller Assistent für Journalist:innen dienen und sie in der Nachrichtenproduktion unterstützen. Ein Beispiel dafür ist ntv, das in Kooperation mit der Deutschen Presse-Agentur (dpa) ein innovatives Redaktionstool entwickelt hat. Dieses Tool nutzt maschinelles Lernen und KI, um Journalist:innen bei der Auswahl und Bearbeitung von Nachrichten zu unterstützen. Es analysiert Agenturmeldungen im dpa-Feed und bietet Vorschläge für Textelemente und Themen sowie eine verbesserte Gewichtung der Nachrichtenrelevanz.

Das Projekt von ntv und dpa zeigt, wie Technologie die mediale Berichterstattung unterstützen kann, ohne die redaktionelle Entscheidungsgewalt zu ersetzen. Dieses Gleichgewicht zwischen menschlicher Urteilskraft und maschineller Effizienz könnte ein Modell für den zukünftigen Nachrichtenjournalismus darstellen.